通常,可以使用不同类型的输入来共享内容,例如触控笔、手指、非触摸手势输入等等。根据各种实现,内容可以在本地邻近的设备之间和/或彼此相距遥远的设备之间共享。在名为“Sharing across environments”的专利申请中,微软介绍了一种跨环境共享的方法,从而允许输入设备能够用于在环境之间共享内容。例如,可以通过手势从第一VR环境中选择内容,并将所述内容共享到第二个VR环境。

跨环境共享技术能够在不同的虚拟现实环境之间共享。例如,VR环境可以包括表示与不同的各自用户相关联的VR环境的子区域的不同工作空间。因此,不同的用户可以合作在各自的工作空间之间共享内容。至少在一些实现中,从一个工作空间到另一个工作空间的内容共享会导致内容在不同的客户端设备之间共享,例如托管各自工作空间的客户端设备。

在另一个例子中,基于不同用户之间的合作共享手势,内容在不同的VR环境之间共享。例如,第一用户从第一VR环境中选择内容,并与与第二VR环境相关联的第二用户进行共享手势。例如,第一和第二VR环境通过不同的设备呈现。作为对所述共享手势的响应,所述内容从所述第一VR环境传播到所述第二VR环境。

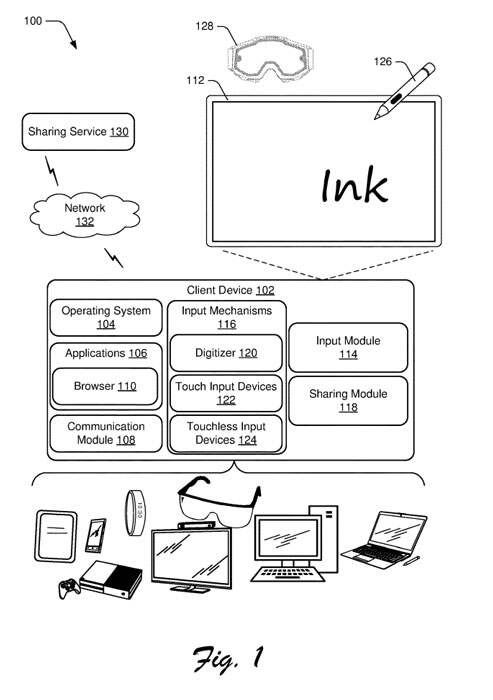

图1是示例实现中的环境100的图示,客户端设备102包括显示设备112、输入模块114、输入机制116和共享模块118。

输入模块114代表使客户端设备102接收输入。输入机制116通常表示用于接收到客户端设备102的输入的不同功能,并包括接触式输入设备122和非接触式输入设备124。输入机制116的示例包括手势敏感传感器和设备。

所述非接触式输入设备124配置为接收各种非接触式输入,例如通过对人体手势的视觉识别、对象扫描、语音识别、颜色识别等。

例如,输入模块114可以利用非接触式输入设备124来执行骨骼映射以及相对于人体的特定点的特征提取,以追踪一个或多个用户并执行运动分析。

根据各种实现,共享模块118表示用于执行跨环境共享技术。

环境100包括可穿戴设备128,其表示所述非接触式输入设备124的实现。通常,可穿戴设备128代表呈现虚拟现实环境的功能。

所述可穿戴设备128包括向佩戴用户显示图形和呈现音频输出的输出功能。所述可穿戴设备128同时包括用于检测诸如用户手势和运动等非接触式输入的摄像头和/或其他传感器。可选地或额外地,可穿戴设备128可与用于检测非触摸输入的第三方摄像头或其他传感器一起使用。

所述环境100包括共享服务130,所述客户端设备102可以例如通过网络132与之通信。通常,可以利用共享服务130来执行本文所述的跨环境共享的各个方面。网络132可以以各种方式实现,例如有线网络、无线网络及其组合。

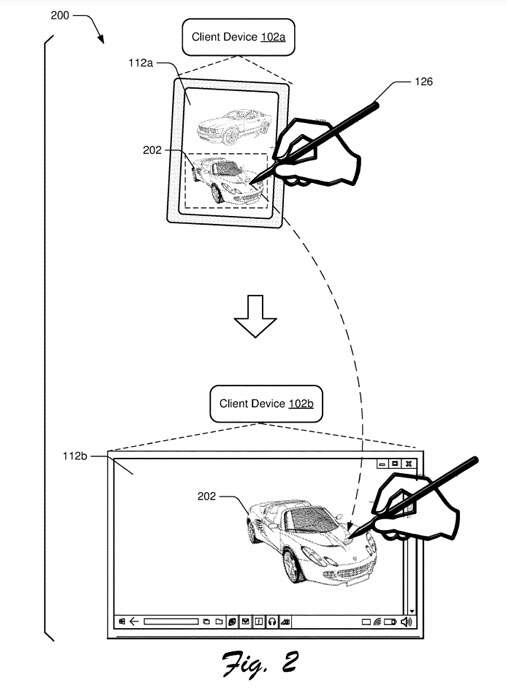

图2描述了用于根据一个或多个实施例跨设备共享的笔的示例实施场景200。场景200的上部包括客户端设备102a,它表示上面描述的客户端设备102的实例。根据场景200,用户操纵笔126选择内容202。

在这个特定场景中,内容202表示在客户机设备102a的显示器112a上显示的图像。本场景和以下场景中图像的使用仅用于说明目的,并且应当理解,此处描述的技术可用于共享任何类型的内容,例如视频、音频、文件、文件夹、网络位置等等。

响应于内容202的选择,内容202的副本与笔126配对。例如,笔126具有唯一的标识,例如基于识别笔126的内部电子元件。在至少一些实现中,响应于内容202的选择,将内容202的副本上传到共享服务130,该共享服务130将该副本存储为与笔126相关联。

继续到场景200的下部,用户在代表客户端设备102的不同实例的客户端设备102b的显示器112b上轻击笔126。例如,客户机设备102a、102b表示位于特定位置(如办公室、会议室、家庭等)的不同设备。或者,客户端设备102a、102b彼此相距较远。

继续执行场景200,在显示器112b上轻击笔126,将内容202复制到客户端设备102b。例如,将内容202共享(例如,粘贴)到客户端设备102b并显示在显示器112b上。在至少一些实现中,在显示器112b上轻击笔126导致客户端设备102b以笔126的身份查询共享服务130。因此,共享服务130识别出内容202已被笔126选中,从而将内容202的副本通信给客户端设备102b。

另外,客户端设备102a、102b可以具有直接连接,例如设备之间的直接有线和/或无线连接。直接连接的例子包括电缆连接、蓝牙、WiFi direct等等。在该场景中,客户端设备102b检测到向显示器112b输入的笔,从而以笔126的标识向客户端设备102a查询。

所述客户端设备102a检测到所述内容202已被所述笔126选中,从而通过所述直接连接将所述内容202的副本通信到所述客户端设备102b。

因此,场景200说明可以将内容的实例绑定到诸如笔126之类的输入设备,使得内容是可移植的并且可以在各种不同位置的各种不同设备之间共享。

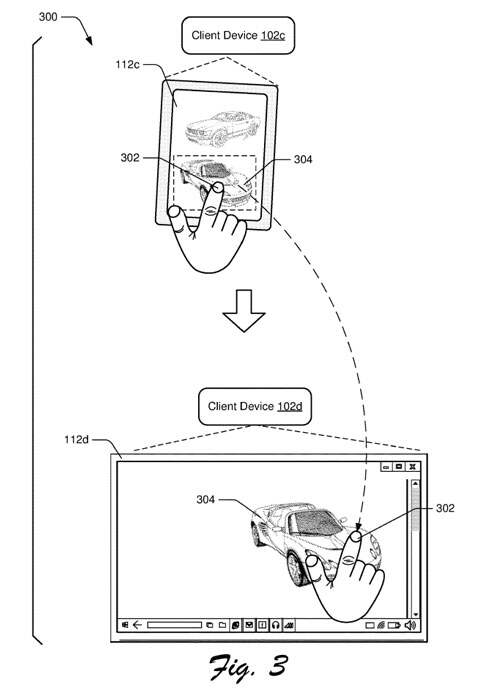

图3描述了用于根据一个或多个实现在设备之间共享的触摸输入的示例实施方案300。场景300的上部包括客户端设备102c,它表示上面描述的客户端设备102的实例。根据场景300,用户操作手指302来选择内容304。在这个特定的场景中,内容304表示在客户端设备102c的显示器112c上显示的图像。

响应用户对内容304的选择,内容304被绑定到用户的标识。例如,将内容304保存到用户的剪贴板,例如由客户端设备102c和/或共享服务130维护的剪贴板。通常,可以采用各种技术将内容304绑定到用户的身份。例如,可以使用生物识别来识别用户,例如通过对显示器112c上的手指302的指纹识别,客户端设备102c采用的面部识别,等等。

继续到场景300的下部,用户在不同客户端设备102d的显示器112d上轻敲他们的手指302。因此,将内容304共享给客户端设备102d。例如,客户端设备102d捕获用户的识别信息,例如生物识别数据(例如,手指302的指纹)、身份验证数据等等。

然后,客户端设备102d用识别信息查询共享服务130。所述共享服务130确定所述内容304已被所述用户选择,并因此将所述内容304的副本通信给所述客户端设备102d。

另外,通过客户端设备102c、102d之间的直接协商共享内容304的副本。例如,响应于检测用户的身份,客户端设备102d用该身份查询客户端设备102c。因此,客户端设备102c将内容304的副本通信给客户端设备102c,例如通过客户端设备102c和客户端设备102d之间的直接连接。

因此,场景300说明了可以利用跨环境共享技术将内容直接绑定到用户标识,这样内容就可以基于用户标识进行移植和共享。

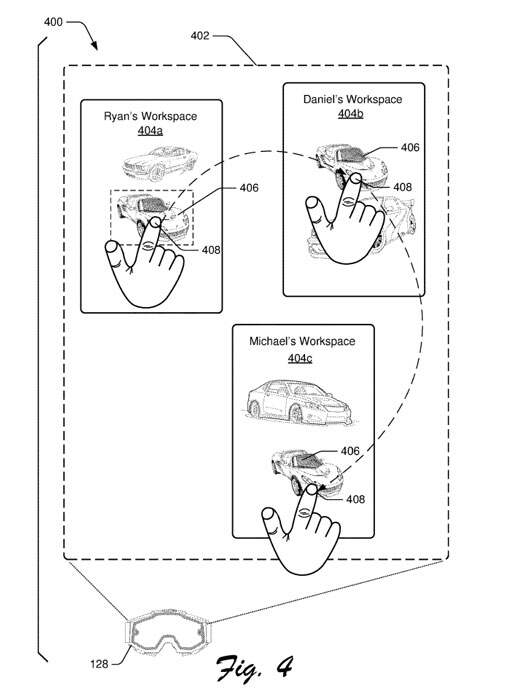

图4描述了通过VR环境进行共享的示例实施方案400。场景400包括可穿戴设备128和通过可穿戴设备128呈现的VR环境402。例如,佩戴所述可穿戴设备128的用户浏览所述VR环境402,并且可以与所述VR环境402的各个方面进行交互和操作。

通常,VR环境402可以以各种方式实现,例如完全虚拟现实环境、混合现实环境、增强现实环境等等。

VR环境402包括不同工作空间的可视化表示,包括工作空间404a、工作空间404b和工作空间404c。通常,每个工作区404a-404c与不同的用户和/或用户标识相关联。

至少在一个实施例中,工作区404b、404c表示不同设备的状态信息,并且从设备通信到可穿戴设备128。

在特定示例中,工作空间404a与佩戴可穿戴设备128的用户的身份相关联。因此,用户从其工作区404a中选择内容406,并将内容406共享到工作区404b、404c。例如,用户用手指408向工作区404a中的内容406应用选择手势,然后用手指408向工作区404b、404c应用共享手势。

通常,选择手势和共享手势表示手指408的不同动作,可穿戴设备128识别所述动作分别绑定到不同的特定动作,例如选择和共享。

根据各种实现,共享内容406致使VR环境402更新,以指示工作区404b、404c现在具有内容406的副本。另外,可以相应地将内容406从可穿戴设备128共享到与工作空间404b、404c相关联的设备。

因此,场景400说明了用于跨环境共享的技术可用于在VR环境内和跨绑定到VR环境的设备共享内容。

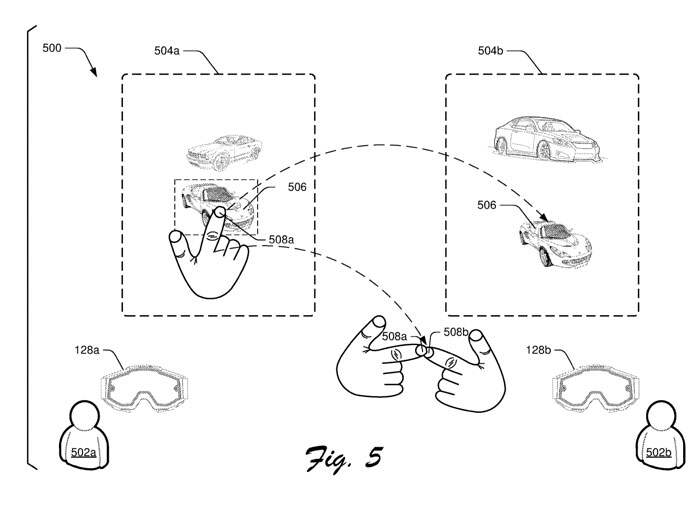

图5描述了用于根据一个或多个实施方案通过VR环境进行共享的示例实施方案500。场景500中,用户502a佩戴可穿戴设备128a,用户502b佩戴可穿戴设备128b。通常,所述可穿戴设备128a、128b表示所述可穿戴设备128的实例。

用户502a通过可穿戴设备128a观看VR环境504a并与之交互,用户502b通过可穿戴设备128b查看VR环境504b并与之交互。

例如,虚拟现实环境504a、504b分别表示与用户502a、502b相关联的不同虚拟现实环境。另外,VR环境504a、504b表示用户502a、502b共享的公共VR环境的不同门户。

对于场景500,用户502a用手指508a从VR环境504a中选择内容506。所述内容506通常表示与所述VR环境504a一起存储的图像。

例如,内容506由与用户502a相关联的客户端设备和/或由共享服务130存储。用户502a选择内容506后,通过共享手势将内容506共享给用户502b。

用户502a用自己的手指508a轻击用户502b的手指508b。据此,所述可穿戴设备128a和/或所述可穿戴设备128b检测所述共享手势,并使所述内容506的副本共享给所述用户502a的VR环境504a。例如,所述可穿戴设备128a和/或所述可穿戴设备128b包括用于感知手指508a、508b之间的接近和/或接触的摄像头。

在示例实现中,将内容506的副本共享给共享服务130,从而将内容506的副本共享给由共享服务130和/或由用户502b的一个或多个客户端设备维护的VR环境504b的表示。

另外,将内容506的副本从用户502a的客户端设备直接共享到用户502b的客户端设备,例如通过网络连接或客户端设备之间的直接连接。

因此,场景500说明了用于跨环境共享的技术可以通过参与VR环境的用户之间的交互,并通过VR环境共享内容。

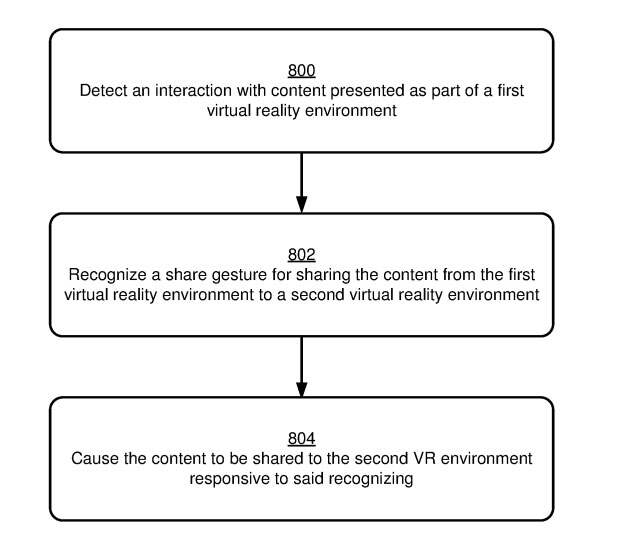

图8是流程图。

步骤800检测与作为第一个虚拟现实环境的一部分呈现的内容的交互。例如,共享模块118检测用户选择在第一VR环境中表示的内容。例如,在通过可穿戴设备128呈现的VR环境中可视化地表示所述内容。

步骤802识别用于将内容从第一虚拟现实环境共享到第二虚拟现实环境的共享手势。例如,第二虚拟现实环境与第一虚拟现实环境分开显示。其中,第一VR环境和第二VR环境分别显示在可穿戴设备128的不同实例中。

至少在一个实现中,共享手势涉及不同用户之间的物理接触。例如,第一用户从第一VR环境中选择内容。然后,第一用户与与第二VR环境相关联的第二用户进行合作手势。协作手势可以以各种方式实现,例如用户之间的手指触摸、第一次碰撞等等。

或者,共享手势表示不涉及物理接触,但涉及由第一用户和第二用户执行的不同的非接触手势的非接触合作手势。通常,协作手势将来自多个用户的手势输入组合成一个聚合手势,而聚合手势识别为共享手势。

根据不同的实现,共享手势有不同的识别方式。例如,呈现第一VR环境或第二VR环境的可穿戴设备可以识别共享手势并产生与手势相关的输入信号。另外,共享手势可以协同识别。例如,呈现第一VR环境的第一设备可以识别共享手势的第一部分,并且呈现第二VR环境的第二设备可以识别共享手势的第二不同部分。

因此,两个设备可以相互通信以组合手势的不同部分,并确定将不同部分组合以生成共享手势。

步骤804致使内容共享到响应于所述识别的第二VR环境。例如,所述内容从承载第一VR环境的设备传输到承载第二VR环境的设备。

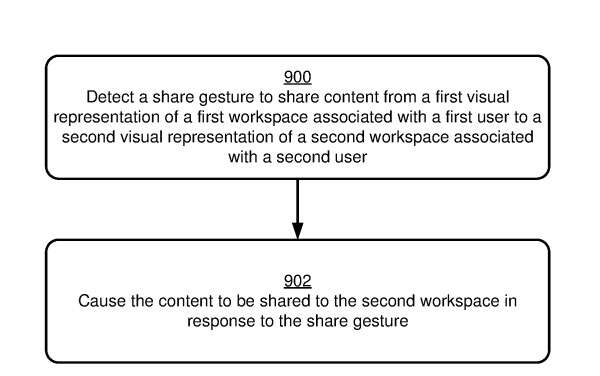

图9描述了用于根据一个或多个实现在虚拟现实环境中共享内容的示例过程。

步骤900检测共享手势,以将内容从与第一用户关联的第一工作空间的第一视觉表示形式共享到与第二用户关联的第二工作空间的第二视觉表示形式。例如,第一视觉表示和第二视觉表示作为单个VR环境的一部分显示。例如,VR环境是通过单个设备呈现的。

通常,不同工作区的可视化表示可以以不同的方式表示。例如,视觉表示可以在VR环境的不同各自的视觉区域中呈现,例如在场景400中所描述的。

至少在一个实施例中,工作区为不同的用户表示不同的设备状态。例如,工作区代表不同用户的各自客户机设备。因此,与VR环境中工作空间的可视化表示的交互可能导致不同客户端设备的状态发生相应的变化,例如客户端设备之间的内容移动。

共享手势可以以各种方式实现,例如单个用户的非触摸手势、涉及多个用户的合作手势、触控组件的触控手势等等。

步骤902使内容响应于所述共享手势被共享到所述第二工作空间。例如,内容的可视化表示在第二个工作空间的可视化表示中显示,作为内容共享到第二个工作空间的指示。

可以通过多种方式实现向第二个工作空间共享内容。例如,可以将内容从与第一个工作区关联的客户端设备通信到与第二个工作区关联的客户端设备。另外,可以将内容共享到第二用户的网络存储位置,例如从客户端设备和/或第一用户的网络存储位置。

来源:映维网

投稿:tougao@arinchina.com

稿件/商务合作: 向前(微信 Shixiangqian7)电话:18700987744

创始人:张明军(微信 13720775110)

更多精彩内容,请关注ARinChina微信公众号(ID:X增强现实)

评论