随着眼动追踪正逐渐成为VR头显的标配,利用用户注视点的应用正在不断增加和优化。在名为“Gaze-guided image capture”的专利申请中,Meta就介绍了一种根据用户注视来捕获图像的方法。

在一种实现方式中,头戴式设备包括眼动追踪系统、第一图像传感器、第二图像传感器和处理逻辑。眼动追踪系统生成用户眼睛的注视方向。处理逻辑接收注视方向并在第一图像传感器和第二图像传感器之间进行选择以捕获注视引导的图像。例如,可以选择具有与注视方向相对应的FOV的图像传感器来捕获注视引导的图像。

在一个实施例中,基于用户的注视方向从一个或多个图像生成一个或更多个注视引导图像。生成注视引导图像包括对图像中的一个或多个进行数字裁剪。生成注视引导图像包括响应于注视方向旋转摄像头。

响应于注视方向生成注视引导图像允许用户捕获与他们注视/观看的位置相关的图像,而不需要额外的努力。另外,响应于用户的注视方向生成注视引导图像允许一个或多个摄像头捕获聚焦景深的图像。响应于眼动追踪系统确定的注视方向,摄像头可以聚焦到近场对象(靠近用户的花朵)或远场对象(例如远处的山脉)。

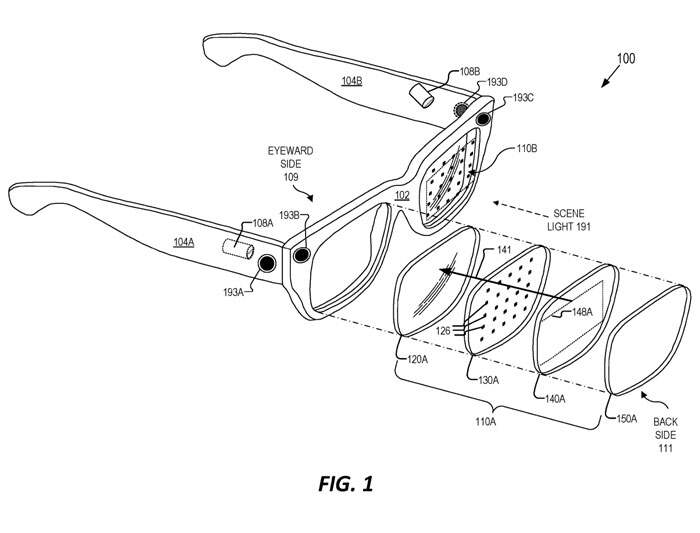

图1示出了一个头戴式设备100。所示的头戴式设备100包含摄像头108A和108B。摄像头108A和108B可以直接或间接地对视窗区域进行成像。例如,光学元件110A和/或110B可以具有光学组合器(未具体示出),光学组合器配置为将光从视窗重定向到摄像头108A和/或者108B。

除了图像传感器之外,头戴式设备100的各种其他传感器可以配置为捕获用于确定眼睛的注视方向的眼睛数据。超声或光检测和测距(LIDAR)传感器可以配置在框架102中,以例如通过检测眼睛的角膜的位置来检测用户眼睛的位置。

包括在框架102或光学元件110A和/或110B中的分立光电二极管同样可以用于检测用户眼睛的位置。例如,分立光电二极管可以用来检测从眼睛反射的光的“闪烁”。

在图1所示的特定示例中,头戴式设备包括四个摄像头193A、193B、193C和193D。

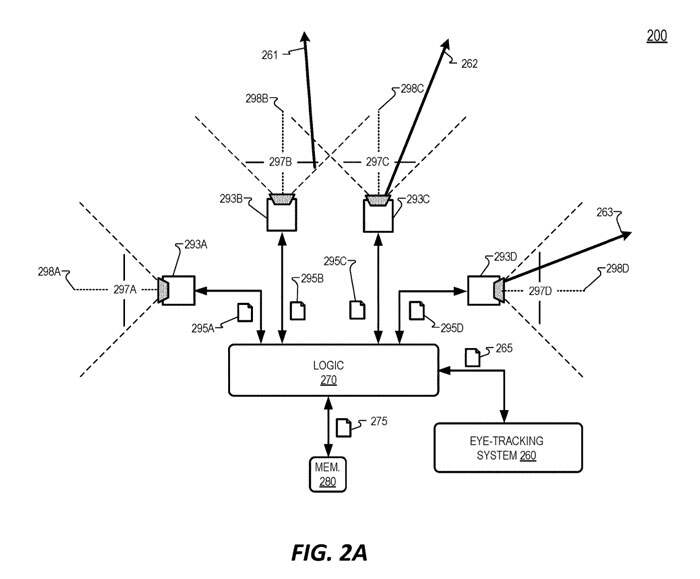

图2A示出了一个注视引导图像系统200。注视引导图像系统200可以包括在诸如头戴式设备100之类的头戴式装置中。注视引导图像系统200包括处理逻辑270、存储器280、眼动追踪系统260以及摄像头293A、293B、293C和293D(统称为摄像头293)。

摄像头293可以用作摄像头193A-193D,并且可以包括关于摄像头193A-193所描述的类似特征。每个摄像头293可以包括配置为将图像光聚焦到图像传感器上的透镜组件。

在图2A中,第一摄像头293A包括第一图像传感器,并配置为捕获头戴式设备的外部环境的第一图像295A。第一图像传感器具有第一视场(FOV)297A,并且轴298A示出第一FOV 297A的中间。轴298A可对应于第一摄像头293A的透镜组件的光轴,并且轴298A可以与第一图像传感器的中间相交。第一照摄像头293A配置为向处理逻辑270提供第一图像295A。

第二摄像头293B包括第二图像传感器,第二图像感测器配置为捕获头戴式设备的外部环境的第二图像295B。第二图像传感器具有FOV 297B的第二视场,并且轴298B示出了第二FOV 297B的中间。轴298B可对应于第二摄像头293B的透镜组件的光轴,并且轴298B可以与第二图像传感器的中间相交。第二照摄像头293B配置为向处理逻辑270提供第二图像295B。

第三摄像头293C包括第三图像传感器,第三图像感测器被配置为捕获头戴式设备的外部环境的第三图像295C。第三图像传感器具有FOV 297C的第三视场,并且轴298C示出了第三FOV 297C的中间。轴298C可对应于第三摄像头293C的透镜组件的光轴,并且轴298C可以与第三图像传感器的中间相交。第三照摄像头293C配置为向处理逻辑270提供第三图像295C。

第四摄像头293D包括第四图像传感器,第四图像感测器被配置为捕获头戴式设备的外部环境的第四图像295D。第四图像传感器具有FOV 297D的第四视场,并且轴298D示出了第四FOV 297D的中间。轴298D可对应于第四摄像头293D的透镜组件的光轴,并且轴298D可以与第四图像传感器的中间相交。第四照摄像头293D配置为向处理逻辑270提供第四图像295D。

眼动追踪系统260包括一个或多个传感器,传感器配置为确定头戴式设备的视窗区域中的眼睛注视方向。眼动追踪系统260同时可以包括数字或模拟处理逻辑,以帮助确定/计算眼睛的注视方向。可以使用任何合适的技术来确定眼睛的注视方向。例如,眼动追踪系统260可以包括一个或多个摄像头,用于对眼睛进行成像,以确定眼睛的瞳孔位置,从而确定眼睛注视的位置。

在另一个例子中,角膜(和/或眼睛的其他部分)反射的“闪光”用来确定眼睛的位置,然后再用来确定注视方向。在眼动追踪系统260中可以使用结合图1描述的其他传感器,例如超声波传感器、激光雷达传感器和/或分立光电二极管,以检测眼睛的位置以确定注视方向。

眼动追踪系统260配置为生成包括眼睛的注视方向的注视方向数据265,并向处理逻辑270提供注视方向数据265。注视方向数据265可以包括表示聚焦距离和两只眼睛聚焦的方向的会聚数据。

处理逻辑270配置为接收来自眼动追踪系统260的注视方向数据265,并基于注视方向数据选择所选图像传感器以捕获一个或多个注视引导图像265。在图2A所示的实施方式中,处理逻辑270生成注视引导图像275,并将注视引导图像275存储到存储器280。

在一个实施例中,基于包括在注视方向数据265中的注视方向,处理逻辑270选择用于捕获注视引导图像的特定图像传感器。例如,处理逻辑270可以在两个或多个图像传感器之间进行选择,以捕获注视引导的图像。选择所选择的图像传感器来捕获一个或多个注视引导图像可以基于相对于图像传感器的FOV的注视方向(包括在注视方向数据265中)。

图像传感器的FOV可以重叠。在图2A中,FOV 297B与FOV 297C重叠。

图2A示出了注视向量263,其示出了由眼动追踪系统260确定的注视方向。由于注视矢量263在摄像头293D的图像传感器的FOV 297D内,所以处理逻辑270可以选择摄像头293D中的图像传感器来捕获注视引导的图像。

选择摄像头293D来捕获注视引导的图像可以包括取消选择系统中的其他摄像头(在所示的示例中,摄像头293A、293B和293C),使得它们不捕获图像或者不向处理逻辑270提供图像。在这种情况下,由摄像头293D捕获的第四图像295D被存储在存储器280中作为注视引导图像275。

在随后的时间点,用户的注视方向可以改变,使得注视向量262代表随后的注视方向数据265的随后的注视方位。注视矢量262可以包括在FOV 297B和FOV 297C中。处理逻辑270可以选择摄像头的图像传感器,其中注视向量(例如注视向量262)最接近该图像传感器的FOV的中间。

在所示的示例中,摄像头293C的图像传感器可以由处理逻辑270选择为“后续选择的图像传感器”,以捕获注视引导的图像,因为注视向量262比它更靠近FOV 297B的中间(轴298B)更靠近FOV297C的中间(轴线298C)。随后选择的图像传感器可以生成注视引导的图像。

在另一个时间点,用户注视方向改变使得注视向量261代表注视方向数据265的注视方向。注视矢量261可以包括在FOV 297B和FOV 297C中。处理逻辑270可以选择摄像头的图像传感器,其中注视向量(例如注视向量261)最接近该图像传感器的FOV的中间。

在所示的示例中,摄像头293B的图像传感器可以由处理逻辑270选择为“选择的图像传感器”,以捕获注视引导的图像,因为注视向量261比它更靠近FOV 297C的中间(轴298C)更靠近FOV297B的中间(轴线298B)。在这种情况下,由摄像头293B捕获的第二图像295B存储在存储器280中作为注视引导图像275。

图2C示出了头戴式设备的外部环境的示例场景。场景299包括月亮245、山脉241、灌木231、湖泊223以及树木225和235。图2C示出了关于场景299的示例FOV 297A、297B、297C和297D。

在图2C的示例中,由系统200生成的注视引导图像可以包括场景299的在FOV 297D内的部分,因为注视向量263在FOV 297内,因此摄像头293D的图像传感器可以选择为“选择的图像传感器”。在这种情况下,摄像头293D捕获的第四图像295D将是注视引导图像275。

类似地,由系统200生成的注视引导图像可以包括场景299在FOV 297C内的部分,因为注视向量262(进入页面)最接近FOV 297C的中间,所以摄像头293C的图像传感器可以选择为“选择的图像传感器”。在这种情况下,摄像头293C捕获的第三图像295C将是注视引导图像275。

并且,由系统200生成的注视引导图像可以包括场景299在FOV 297B内的部分,因为注视向量261(进入页面)最接近FOV 297B的中间,所以摄像头293B的图像传感器可以选择为“所选图像传感器”。在这种情况下,摄像头293B捕获的第二图像295B将是注视引导图像275。

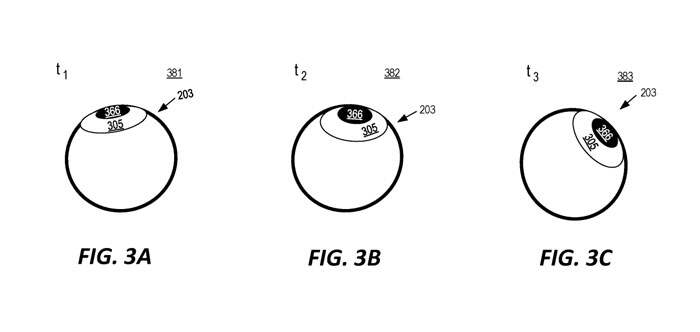

图3A-3C示出了与注视向量相关联的眼睛203的眼睛位置。在时间t1 381,定位眼睛203,如图3A所示。

例如,图3A中的眼睛203的位置可以与注视向量261相对应。在不同的时间t2 382,可以定位眼睛203,如图3B所示。例如,图3B中的眼睛203的位置可以与注视向量262相对应。

在时间t3383,可以定位眼睛203,如图3C所示。例如,图3C中的眼睛203的位置可以与注视向量263相对应。眼睛203的位置可以由合适的眼动追踪系统来测量/确定。例如,眼动追踪系统可以基于眼睛203的瞳孔366的位置,或者基于眼睛203角膜305的位置来确定眼睛203的位置。

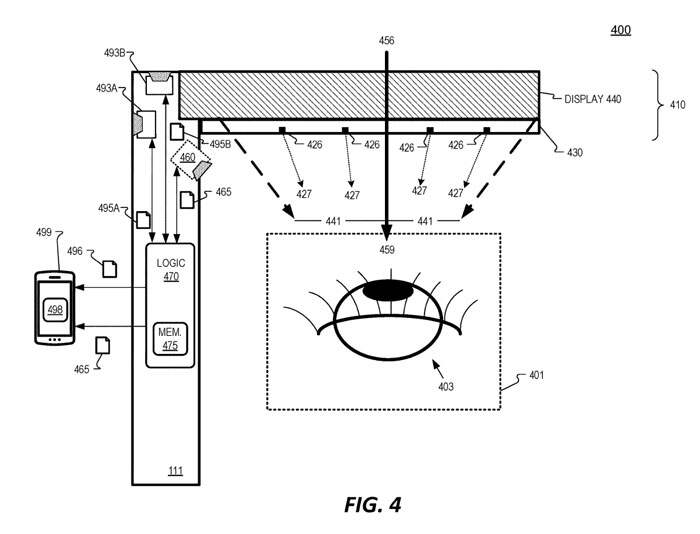

图4示出了处理逻辑470以通信方式耦合到摄像头493A和493B。第一照摄像头493A捕获第一图像495A,第二照摄像头493B捕获第二图像495B。处理逻辑470可以响应于从眼动追踪系统460接收到的注视方向数据465来选择特定的摄像头来捕获图像。

处理逻辑470可以向移动设备499或其他计算设备发送注视方向数据465和图像496。图像496可以包括从摄像头493A和493B接收的一个或多个图像495。移动设备499的处理逻辑498然后可以使用任何技术来生成注视引导的图像。例如,将注视方向数据465和图像496发送到移动设备499以生成注视引导的图像有利于节省头戴设备400的计算能力和处理能力。

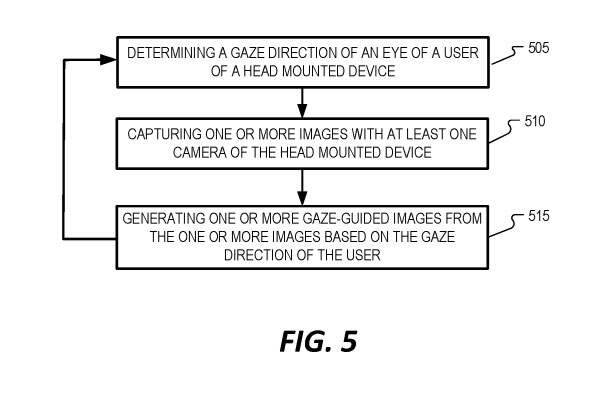

图5示出了示出利用头戴式设备生成注视引导图像的示例过程500的。

在过程框505中,确定(头戴式设备的)用户的眼睛的注视方向。注视方向可以由眼动追踪系统或接收注视方向数据的处理逻辑来确定。

在过程框510中,由头戴式设备的至少一个摄像头捕获一个或多个图像。

在过程框515中,生成一个或多个注视引导图像。所述一个或多个注视引导图像基于用户的注视方向。可以在确定用户眼睛的新注视方向之后返回到过程505,并且重复过程500以基于用户的注视方向生成注视引导图像。

在过程500的实现中,至少一个摄像头被包括在头戴式设备的多个摄像头中,并且生成一个或多个注视引导图像包括在头戴式设备的所述多个摄像头当中选择所选择的摄像头。所选择的摄像头被选择为基于注视方向捕获一个或多个注视引导图像。

在过程500的实现中,生成一个或多个注视引导图像包括裁剪一个或更多个图像以生成注视引导图像,其中响应于相对于至少一个摄像头的视场(FOV)的注视方向裁剪一个或者更多个图像。

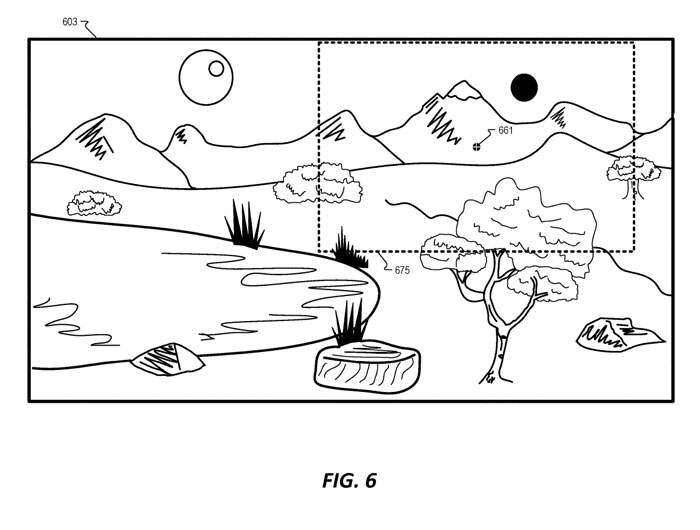

图6示出了根可以用作注视引导图像的示例裁剪图像675。图6包括可以在头戴式设备的摄像头(例如摄像头493B)的FOV中的完整图像603。与图6的注视向量661相对应地确定注视方向。然后基于注视方向(表示所确定的注视方向的注视向量661)从完整图像603数字地裁剪图像675。

裁剪后的图像675可以围绕注视向量661进行裁剪。换言之,用户的注视方向可以穿过裁剪图像675的中间。因此,如果用户正在观看图像603的右上角的山脉,则注视引导的图像将是山脉的,而不是包括图像603的整个场景。

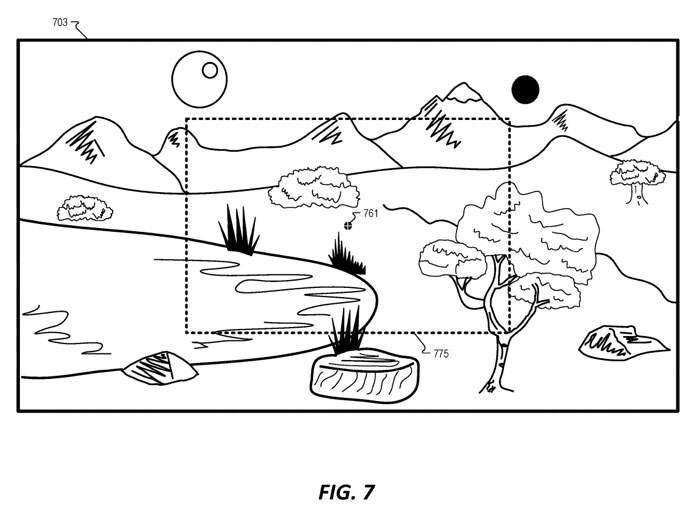

图7示出了可以用作注视引导图像的示例缩放图像775。图7包括可以在头戴式设备的摄像头的FOV中的完整图像703。与图7的注视向量761相对应地确定注视方向。

摄像头的透镜组件的光学变焦特征随后被放大,以基于注视方向来捕获缩放图像775。用户的注视方向可以贯穿缩放图像775的中间。

来源:映维网

投稿:tougao@arinchina.com

稿件/商务合作: 向前(微信 Shixiangqian7)电话:18700987744

创始人:张明军(微信 13720775110)

更多精彩内容,请关注ARinChina微信公众号(ID:X增强现实)

评论